Pour celles et ceux qui suivent mon blog depuis quelques années, vous vous souvenez peut-être de cet article récapitulant les différents systèmes d’interfaces gestuels pour les smartphones. Depuis les premières interfaces imaginées dans les livres de science-fiction, contrôler un ordinateur, une machine, un objet juste par la voix ou le geste a toujours été un rêve, un fantasme. Évidemment, aujourd’hui, ce genre de rêve devient réalité puisque la taille des composants électroniques ne cesse de diminuer et leur coût, de baisser. Il y a aussi le rapprochement des technologies et de l’humain et porter une smartwatch ou dormir avec son téléphone n’est plus vraiment un problème pour beaucoup. L’intimité numérique en quelque sorte.

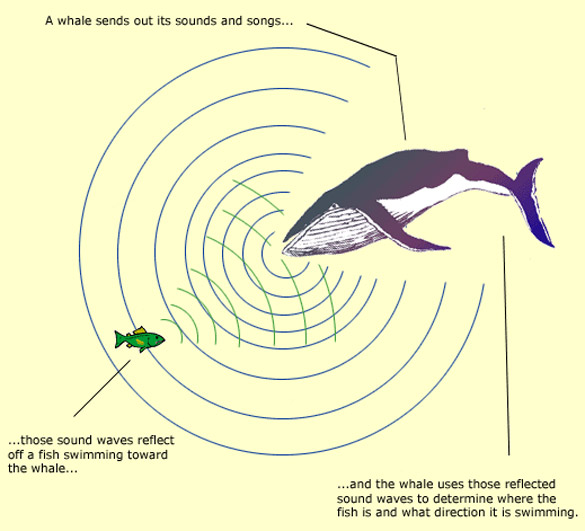

C’est donc avec plaisir que je voulais vous présenter le projet FingerIO, un travail conçu dans un brillant laboratoire de Washington avec une équipe de chercheurs spécialisés dans les sonars. L’idée est simple, utiliser le principe du sonar pour permettre aux utilisateurs d’interagir avec leurs smartphones et smartwatches par des gestes ou même en dessinant avec son doigt sur toute surface à proximité. Pour rappel le sonar (dit « actif« ) émet une impulsion sonore et écoute son écho sur les obstacles qu’elle rencontre. Les bases d’émission et de réception des signaux sont appelés des antennes, tout simplement.

exemple de fonctionnement d’un sonar d’une baleine

À l’origine du projet FingerIO, le professeur Nathaniel Watson et son étudiant Rajalakshmi Nandakumar ont développé ApneaApp, une application qui utilise le smartphone pour détecter l’apnée du sommeil (l’apnée du sommeil provoque des interruptions de respiration pendant que l’on dort, c’est assez dangereux sur le long terme). Après ces recherches et le développement de cette application, les deux chercheurs ont donc continué sur la détection de l’activité humaine grâce aux smartphones afin de développer FingerIO.

Ce qui est brillant dans l’histoire c’est l’utilisation d’une technologie ancienne pour un usage résolument contemporain. En substance, le téléphone émet des ondes sonores non détectables par l’oreille humaine (des ultrasons) et écoute comment ces ondes reviennent à lui. Un algorithme traduit ensuite les données en informations afin de traduire la position d’un mouvement.

La démo de FingerIO

Pour les plus curieux, sachez que pour l’instant il s’agit d’un prototype de recherche qui fonctionne sur les smartphones Android avec au moins 2 micros. Il fonctionne également pour smartwatches Android (avec un seul micro) mais vous ne pourrez interagir qu’au travers de gestes simples et en 2D. Notons également que pour l’instant FingerIO est affecté par le bruit, cela vient perturber le signal sonore et il faudrait en effet filtrer les sons audibles pour l’oreille humaine. Enfin, l’équipe de chercheur est actuellement en train d’explorer différentes options pour la commercialisation de leur dispositif mais aussi sur la façon dont ils pourraient libérer le code source auprès des développeurs qui souhaitent créer des projets avec ce système.

De mon côté, j’ai déjà plusieurs idées qui me viennent en tête… mais j’ai très hâte de pouvoir mettre les mains dans le code et découvrir les usages que différentes entreprises, designers, ingénieurs, etc. en feront !